Dlaczego tak łatwo przeprowadzić test A/B i tak trudno przeanalizować jego wynik?

Podczas konferencji WUD Silesia przeprowadziliśmy warsztaty dotyczące testów A/B. Było to dla nas bardzo ciekawe doświadczenie, którego przebiegiem i wnioskami chcemy się dzisiaj z Wami podzielić. W warsztatach wzięło udział 16 osób o różnym poziomie zaawansowania. Część uczestników miała już do czynienia z testami A/B, dla niektórych był to pierwszy kontakt. Ale o tym za chwilę. Zacznijmy od początku…

Część 1: Metodologia testów A/B

Pierwsza część zawierała sporą dawka teorii na temat metodologii przeprowadzania testów A/B, popartą wieloma praktycznymi przykładami eksperymentów na stronach eSky.

W internecie można znaleźć wiele opisów, w jaki sposób należy przeprowadzać takie testy i interpretować ich wyniki. Niestety, duża część tej wiedzy, nie znajdzie zastosowania w przypadku wielu stron internetowych, czy też w specyficznych obszarach e-commerce.

W przypadku eSky i sektora travel, z eksperymentu na eksperyment dopracowujemy własną metodologię przeprowadzania testów A/B i napotykamy przy tym ciągle na jakieś trudności.

O tym jakiego typu są to trudności opowiedzieliśmy w pierwszej części warsztatów.

Uczestnicy warsztatu wraz z prowadzącym Krzysztofem Kaiserem. Fot. K. Gołąbek

Część 2: Google Optimize

Druga część warsztatów poświęcona była narzędziu Google Optimize, które w eSky wykorzystujemy do przeprowadzania testów A/B.

Dlaczego wybraliśmy akurat to narzędzie?

Jest bezpłatne, zintegrowane z Google Analytics, którego też używamy, posiada naprawdę solidnie wykonany edytor WYSIWYG, więc nawet osoby bez zaplecza programistycznego poradzą sobie w tworzeniu testów. Co jednak dla nas jest najistotniejsze, to możliwość umieszczania własnych styli CSS, uruchamiania jakichkolwiek skryptów javascript i spora liczba ułatwień umożliwiających szybkie tworzenie zmian na stronie, nawet w komponentach opartych na AJAX czy SPA (Single Page Applications).

Dzięki możliwościom Google Optimize zintegrowaliśmy też testy A/B z naszym wewnętrznym narzędziem analitycznym oraz z aplikacją Hotjar, którego też bardzo chętnie używamy.

Uczestnicy poznali interface narzędzia, najczęściej wykorzystywane przez nas funkcje i kilka sprawdzonych przez nas praktyk, dzięki którym można się w miarę skutecznie ustrzec przez niepożądaną „umiejętnością” Optimize – kompletnym zatrzymaniem funkcjonalności strony. W końcu, im więcej skomplikowanych zmian na stronie jest możliwych, tym większe szkody można osiągnąć przez nieumiejętne ich zastosowanie. A uniemożliwienie zakupu na stronie, na którą za pomocą AdWords codziennie jest kierowanych kilkaset tysięcy osób, może naprawdę słono kosztować.

Prowadzący warsztaty – Mariusz Janosz oraz uczestnicy warsztatów. Fot. K.Gołąbek

Część 3: Przygotowanie testów A/B

Tegoroczna edycja WUD Silesia była inspirowana Cyberiadą Stanisława Lema oraz wieloma filmami Sci-Fi. Na potrzeby konferencji WUD Silesia, organizatorzy stworzyli wątek narracyjny, w którym rozgrywała się akcja wszystkich warsztatów. Było to fikcyjne miasto WUDzisław w roku 2038, które czekało na naszą ingerencję badawczą i projektową.

Wraz z uczestnikami stanęliśmy na wysokości zadania i w ostatniej już części warsztatów, podzieleni na grupy, zajęliśmy się optymalizacją strony internetowej WUDzisława. Z przedstawionych kilku hipotez dotyczących problemów, z jakimi spotykają się mieszkańcy i przyjezdni, każdy zespół wybrał jedną, dla której przygotował kilka propozycji optymalizacji. Stroną internetową WUDzisławia, była strona wudsilesia.pl, a mieszkańcy i przyjezdni to użytkownicy tej strony.

Po zaprezentowaniu pomysłów na poprawę użyteczności strony, każdy z zespołów musiał wymyślić za pomocą jakich wskaźników będzie monitorował zmiany w teście A/B. W końcu cały sens eksperymentów to wyłanianie wersji, która w większym stopniu spełnia nasze założenia. W przypadku strony wudsilesia.pl wskaźniki nie opierały się na przychodach z 1000 sesji, gdyż nie takie jest przeznaczenie strony. Dlatego też uczestnicy warsztatów skupili się na poprawie nawigacji pomiędzy poszczególnymi stronami, starając się bardziej zaangażować użytkowników do poznania treści strony.

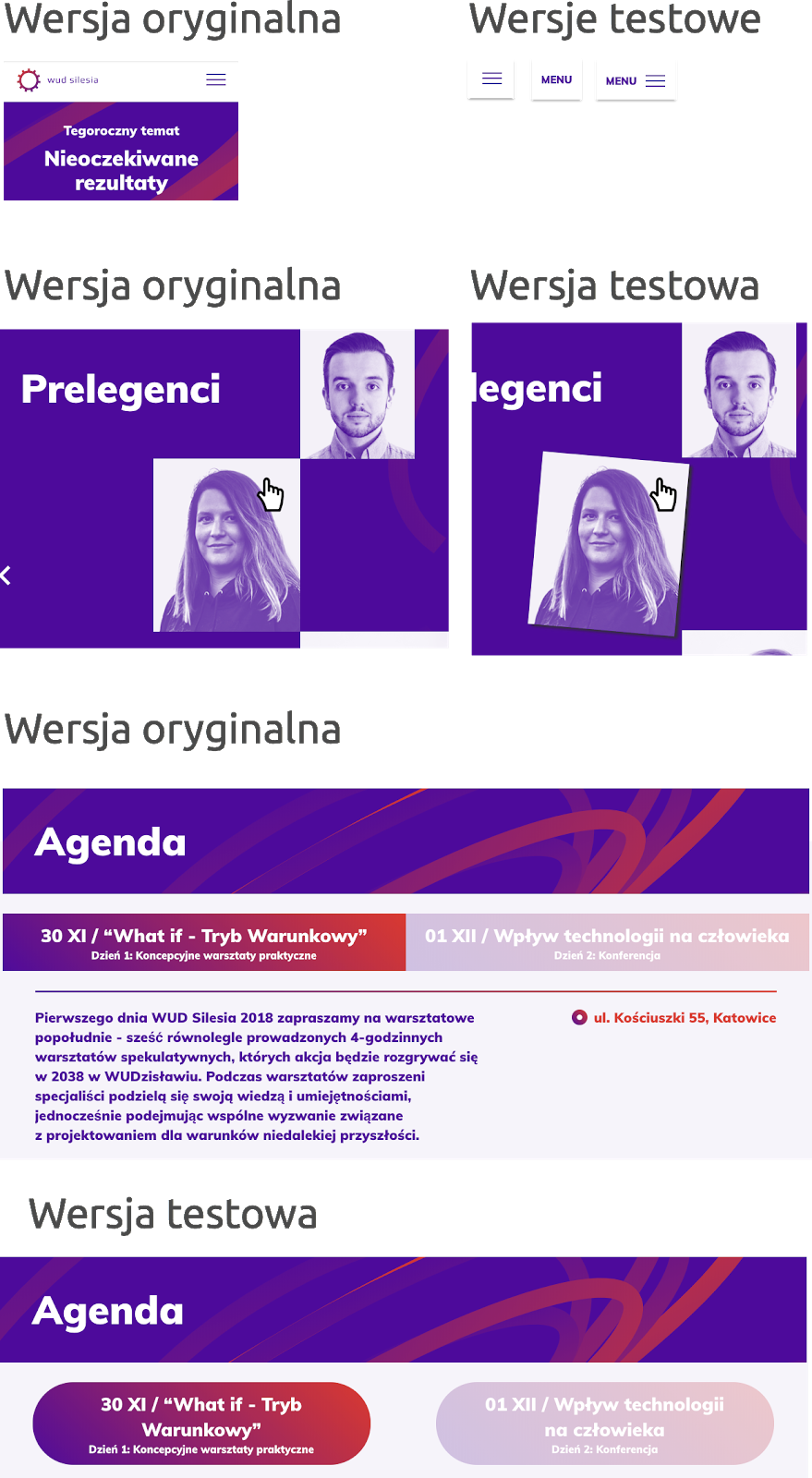

Jeden z zespołów zajął się optymalizacją nawigacji dla użytkowników smartfonów, tworząc kilka wersji menu zamiast klasycznego „hamburgera”. Drugi z zespołów zajął się sekcją z prelegentami na stronie głównej, która według postawionej hipotezy nie do końca dawała użytkownikom poczucie możliwej interakcji (klik w zdjęcie prelegenta wyświetlał jego opis). Ostatni z zespołów zajął się optymalizacją strony z agendą, gdzie według hipotezy elementy przełączające widok poszczególnych dni wydarzenia, wtapiały się zbytnio w tło, nie dając poczucia „klikalności”.

Porównanie strony przed i po zmianach

Każdy z zespołów wykazał się dużą kreatywnością, czego wynikiem było stworzenie kilkunastu wersji testowanych komponentów. Co ciekawe, niektóre z propozycji wymagały zastosowania zmian bezpośrednio w stylach CSS, czy nawet zastosowania prostych skryptów javascript. Sprawdziła się tutaj praca w grupach, gdzie każdy z uczestników dorzucił swoją cegiełkę w postaci wiedzy w obszarach (CSS/JS/HTML). Intuicyjny edytor wizualny Google Optimize dopełnił całości, dzięki czemu każdej z grup udało się uruchomić swój test na produkcyjnej wersji strony wudsilesia.pl.

Krzysztof Kaiser – prowadzący warsztaty. Fot. K. Gołąbek

Podsumowanie warsztatów

Z racji tego, że testy zostały uruchomione już podczas trwania konferencji WUD Silesia, ruch na stronie był już znacznie mniejszy niż wcześniej. Przez tydzień trwania testu, zebrało się około 500 sesji użytkowników w każdym z testów. Dodatkowo każdy test miał kilka wersji testowanego komponentu, czego wynikiem była relatywnie mała próbka użytkowników na każdy wariant komponentu, by można było interpretować wyniki testów. Według zaleceń Google, test powinien trwać co najmniej 2 tygodnie lub przynajmniej jeden z wariantów testowanego komponentu powinien uzyskać co najmniej 95% prawdopodobieństwa przekroczenia wartości podstawowej. Według doświadczeń nabytych podczas wykonywania testów A/B w eSKy, możemy stwierdzić, że w przypadku relatywnie małej ilości sesji biorących udział w teście, czas przeprowadzania testu powinien być znacznie dłuższy niż te 2 tygodnie (często widać jak konwersja poszczególnych wersji komponentów zmienia się w czasie).

Mimo braku możliwości rzetelnej interpretacji wyników uruchomionych testów A/B, najistotniejszy jest fakt, że uczestnicy warsztatów przetestowali w praktyce jak samodzielnie definiować hipotezy oraz nauczyli się tworzyć wskaźniki, za pomocą których będą weryfikowane wyniki.

Cztery godziny warsztatów z tak wymagającego tematu jak testy A/B to mało, a nawet bardzo mało. By zgłębić ten obszar na tyle, by z miesiąca na miesiąc wykresy przychodów firmy pięły się do góry, dzięki prowadzonym eksperymentom, należałoby przeprowadzić cały cykl warsztatowy.

Metodologia przeprowadzania testów, wybór odpowiedniego narzędzia i jego implementacja w sposób nie wpływający na User Experience, tworzenie poszczególnych wariantów komponentów na zaawansowanych technologicznie stronach e-commerce, wreszcie analiza wyników, to podstawy wymagające wielu godzin nauki, często współpracy kilku osób, czy działów.

A to dopiero wstęp, gdyż nie ma uniwersalnego przepisu na dobre testy A/B. Każda branża rządzi się swoimi prawami, potencjalni klienci czy użytkownicy stron mają własne, charakterystyczne dla danego sektora e-commerce zachowania i „wrażliwość transakcyjną”, choć oczywiście pewne elementy zawsze pozostają wspólne (lubimy robić zakupy na bezpiecznych, zaufanych stronach, czy korzystać z podobnych form płatności). Wszystkie te aspekty wymagają indywidualnego podejścia i ciągłego “szlifowania” metodologii testów A/B pod swoją branżę czy nawet firmę.

Mamy nadzieję, że warsztaty, które przeprowadziliśmy na WUD Silesia, stały się dla uczestników początkiem fascynującej, pełnej wyzwań przygody i w niedługim czasie wszyscy odczujemy poprawę jakości doświadczeń użytkowników ecommerce (i nie tylko), która z pewnością dzięki testom A/B jest możliwa.

Jeżeli jesteś zainteresowany rozwojem w obszarze testów A/B, to napisz do nas lub zostaw swój komentarz.